Da es schon an einer genauen Definition von Intelligenz scheitert, gestaltet sich die Erklärung von einer künstlichen Variante mindestens genauso schwierig. Das noch eher philosophische Forschungsgebiet der künstlichen Intelligenz beschäftigt sich mit der Aufgabe einer mechanischen Nachbildung des menschlichen Denkens. Wie bei der geistigen Entwicklung vom Baby zum Erwachsenen, wird sich hier eine gewisse Entfaltung erhofft, wenn auch nicht zwingend identisch zum humanen Pendant. In der Industrie und Medien wird die Formulierung oft für Maschinen oder Computer benutzt die dieses kognitive und logische Verhalten, für das unsere Spezies bekannt ist, scheinbar imitieren und schlaue Entscheidungen treffen.

Künstliche Intelligenz

Lesedauer ca. 3 Minuten

Schwache Leistung?

Bei Konzepten wie autonomem Fahren oder Gesichtserkennung spricht man genau genommen von "schwacher" künstlicher Intelligenz, da diese Anwendungen nicht mehr der Definition im engeren Sinne entsprechen - es fehlt ihnen der eben beschriebene geistige Ausbau ihrer Fähigkeiten und die Entscheidungskraft ist stark auf das Aufgabenfeld eingeschränkt.

Kritiker und Verfechter der philosophischen Begriffserklärung argumentieren, dass es schließlich keine echte Intelligenz ist wenn eine Aufgabe, z.B. Sprache in Text umwandeln, von einer Maschine bewältigt wird.

Hierzu passt 'Tesler's Theorem' welches lautet: "Künstliche Intelligenz ist alles das, was noch nicht geschafft wurde". Das beschreibt den Disput recht treffend. Sobald ein neues Projekt realisiert wurde, verliert es eine gewisse Magie. Es gibt jetzt einen festen reproduzierbaren Prozess und dieser beinhaltet vorgeschriebene Rechenoperationen um ein analoges Resultat zu erzielen.

"Künstliche Intelligenz ist alles das, was noch nicht geschafft wurde"

K.I. or not K.I.?

Die Entwicklungen der letzten Jahre sind trotzdem nicht zu verschmähen.

Projekte, wie zum Beispiel autonomes Fahren Level 5, müssen viele Teilprobleme effizient lösen und diese Lösungen müssen miteinander arbeiten.

So zum Beispiel ethische und moralische Entscheidungskraft bei einem Unfall unter Beweis stellen, was ebenso eine theoretische und vielleicht auch philosophische Auseinandersetzung mit dem menschlichen Gehirn und Entscheidungsprozessen impliziert. Den Entwicklern und Forschern auf diesem Gebiet den Stempel der künstlichen Intelligenz zu entziehen wäre aber falsch. Sie haben sich ein (zumindest "schwaches") Siegel verdient.

Es besteht für beide Parteien der Diskussion kein Zweifel, dass die Maschine etwas gelernt hat und dieses Wissen auch anwenden kann. Allerdings sind es die Entwickler, die der schwachen künstlichen Intelligenz sagen, wie und was sie lernen soll. Es hat keine eigenständige geistige Entwicklung stattgefunden.

Maschinelles Lernen

Der Prozess des “Lernens” bedient sich hierbei dem großen Forschungsgebiet des maschinellen Lernens. Nahezu alle großen Produkte die den Titel künstliche Intelligenz tragen, sind eine Summe aus Ergebnissen dieser Disziplin.

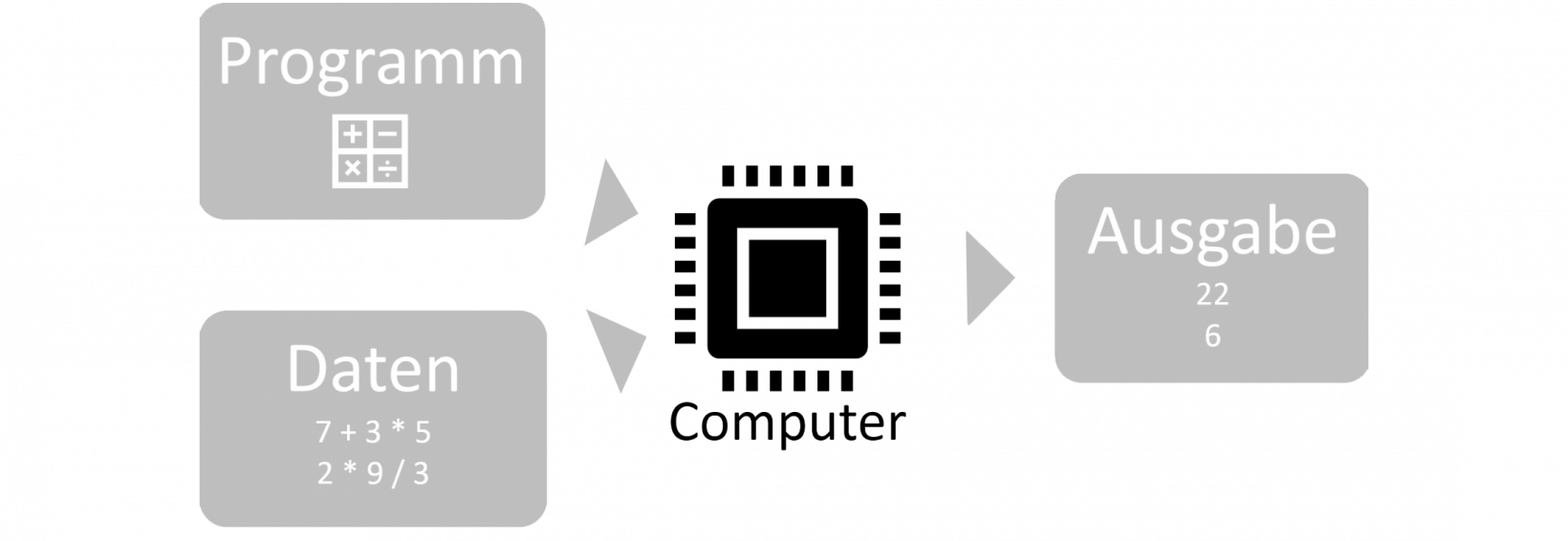

Im Gegensatz zur herkömmlichen Problemlösung mit Hilfe des Computers, die sich auf die Ausgabe einer (möglichen) Lösung konzentriert, wird beim Machine Learning ein Programm erzeugt.

Ein Beispiel: Ein Entwickler kann das Programm "Taschenrechner" schreiben, welches dann aus gegeben Daten, in diesem Fall Gleichungen, mit Hilfe des Computers Lösungen erzeugt.

Problemlösen mit Hilfe des Computers

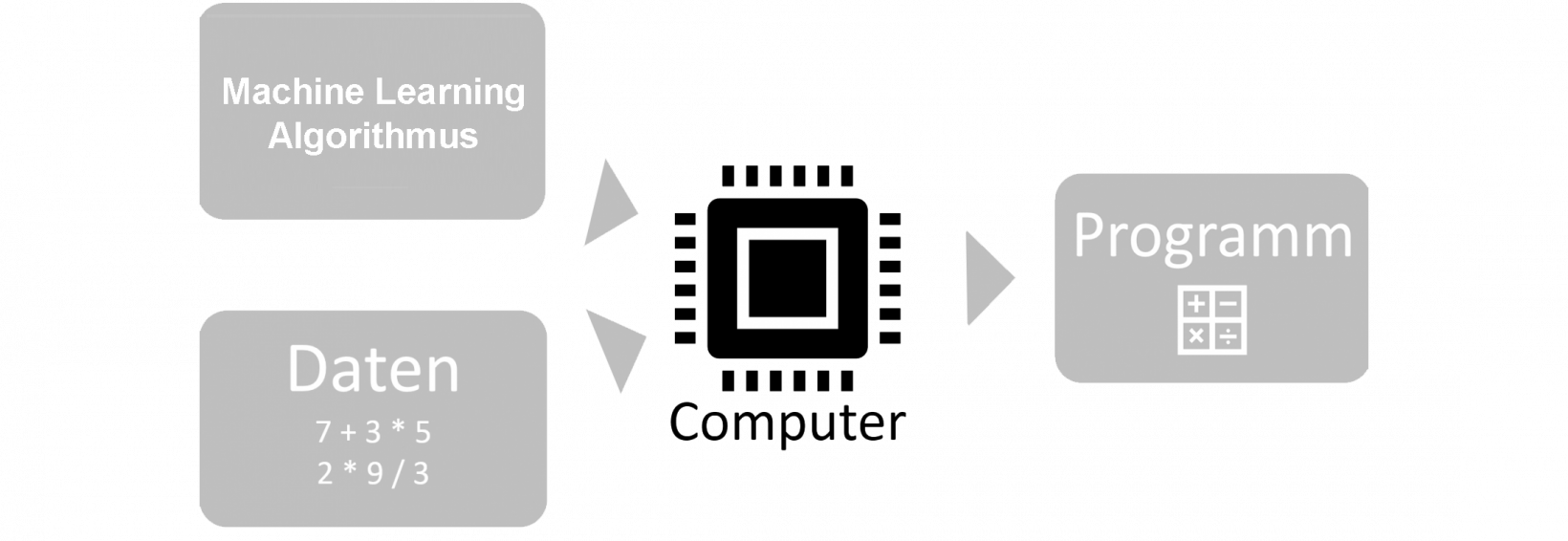

Mit Hilfe von maschinellem Lernen kann man nun den Prozess des Schreibens dieses Programmes abstrahieren und zum Beispiel über bereits gelöste Gleichungen das Programm "Taschenrechner" erzeugen, welches folgend benutzt werden kann, um neue Aufgaben zu lösen.

Problemlösen mit Hilfe von ML

Während der Taschenrechner ein konstruiertes Beispiel und analog ein einfaches Programm ist, hilft Maschinelles Lernen dabei Probleme zu lösen, bei denen das Schreiben bzw. Entwickeln eines aus menschlicher Hand geschaffenem Programmcodes komplex ist.

Problematisch daran ist allerdings, dass Programme aus der Schmiede eines Maschine-Learning-Ansatzes zwar reibungslos funktionieren (können), allerdings selbst eine Art Black-Box darstellen.

Ihr menschen-generiertes Pendant würde eine durchschaubare und feste Befehlsfolge besitzen und somit zulassen, die Argumentation die zu einer gewissen Handlung geführt haben, nachzuvollziehen. Wenn maschinelles Lernen ein Programm generiert, ist dies (bisher zumindest) nicht wirklich analysierbar.

Tic-Tac-Toe

M.L. und K.I.: Zwei Akronyme im beispielhaften Zusammenspiel

Ein Rezept für eine optimale erster Spieler-Strategie bei Tic-Tac-Toe lautet:

- Hat jemand zwei Felder in einer Reihe (folgend Gefahr), nimm das verbleibende Feld, sonst …

- Wenn ein Zug zwei Gefahren aus Sicht des Gegners verursacht, spiele diesen Zug. Sonst...

- Nimm das zentrale Feld wenn frei. Sonst…

- Wenn der Gegner in eine Ecke gesetzt hat, nimm das Feld gegenüber. Sonst …

- Nimm eine freie Ecke. Sonst…

- Nimm ein freies Feld.

In der Gesamtheit bilden diese Regeln eine schwache künstliche Intelligenz, einfach weil dieser Tic-Tac-Toe Computer-Gegner nach außen hin clever spielt und somit dem Menschen einen Entscheidungsprozess vorgaukelt, obwohl dahinter eigentlich ein von einem Programmierer geschriebenes festes Programm steckt, ganz ohne maschinelles Lernen.

Gleichzeitig ließe sich aber ein Regelwerk (ein Programm) zum Spielen von Tic-Tac-Toe - wenn auch nicht unbedingt in so ausdrücklich verbaler Form - mit Hilfe maschinellem Lernen generieren und dann vom Computer spielen.

Fazit

Während die Produktbeschreibungen vieler Innovationen in Kinderschuhen die Wörter künstlich und Intelligenz beinhalten um Investoren zu locken, bleibt die Frage ob man sich dort genug mit der eigentlichen Bedeutung dieser zwei Wörter beschäftigt hat.

Im weiteren Sinne fehlt die Portfolios der Produkte eigentlich auch nur das Adjektiv "schwach" um eine fachlich korrekte Beschreibung zu bieten und sind somit nicht gänzlich falsch.

Findet sich allerdings den Begriff maschinelles Lernen, ist das ein größerer Garant dafür, dass sich der Anbieter in dem weiten Feld der maschinen-erzeugten Programme wirklich auskennt.

EN

EN